Tình trạng hỗn loạn tại OpenAI đẩy CEO Sam Altman vào thế khó

Bảo Ngọc

24/05/2024

Nhiều nhà lãnh đạo chủ chốt của OpenAI vừa quyết định “dứt áo ra đi", để lại nỗi lo ngại lớn về vấn đề an toàn AI…

OpenAI đã có một tuần đầy khó khăn, rơi vào thế bị động sau khi nhiều nhà nghiên cứu về an toàn AI quan trọng rời bỏ tổ chức. Bên cạnh đó, nhiều NDA (thỏa thuận bảo mật) nghiêm ngặt của công ty buộc nhân viên cũ không được lên tiếng và giới chuyên môn phản ứng dữ dội với phiên bản mới của ChatGPT, theo Business Insider.

Lùm xùm xoay quanh quyết định từ chức của nhà nghiên cứu cấp cao Jan Leike và Giám đốc Khoa học Ilya Sutskever vào tuần trước thậm chí đã buộc các lãnh đạo của OpenAI, bao gồm cả CEO Sam Altman, phải đưa ra tuyên bố công khai bảo vệ nỗ lực của hãng trong việc kiểm soát rủi ro AI.

Khi Vox hỏi về các thỏa thuận bắt buộc chặt chẽ của OpenAI, CEO Altman đã trả lời rằng đây là một trong "số ít lần" mà ông cảm thấy "thực sự xấu hổ" khi điều hành OpenAI. Ông khẳng định không hề biết về các điều khoản được áp dụng đối với nhân viên nghỉ việc và tuyên bố công ty đang nỗ lực khắc phục vấn đề.

Đây là sự thừa nhận hiếm hoi từ Sam Altman, dù đã cố xây dựng hình tượng tương đối bình tĩnh giữa bối cảnh hỗn loạn hiện tại của OpenAI. Cuộc đảo chính thất bại nhằm loại bỏ ông vào năm ngoái cuối cùng lại củng cố danh tiếng thêm cho vị CEO, nhưng có vẻ như những “vết nứt” bên trong tổ chức OpenAI đang dần lộ rõ.

NHÓM NGHIÊN CỨU VỀ AN TOÀN AI TAN RÃ

Leike và Sutskever, những người đứng đầu nhóm chịu trách nhiệm đảm bảo trí tuệ nhân tạo nói chung không lừa đảo và gây hại cho nhân loại, đều quyết định từ chức vào tuần trước.

Jan Leike sau đó đăng tải một bài dài trên X, cáo buộc những người chủ cũ đã đặt "sản phẩm hào nhoáng" lên trên sự an toàn. Ông bày tỏ nhóm an toàn đã phải "đấu tranh và tính toán" và "việc thực hiện nghiên cứu ngày càng trở nên khó khăn".

Nhanh chóng xử lý khủng hoảng, CEO Altman chia sẻ lại bài đăng của Leike và nói thêm rằng: "Ông ấy nói đúng, chúng tôi còn rất nhiều việc phải làm; chúng tôi cam kết thực hiện điều đó".

Leike và Sutskever không phải là những người duy nhất rời đi.

Theo báo cáo của The Information, hai nhà nghiên cứu an toàn là Leopold Aschenbrenner và Pavel Izmailov gần đây đã bị sa thải với cáo buộc làm rò rỉ thông tin.

Theo hồ sơ trên LinkedIn, các nhà nghiên cứu về an toàn và quản trị Daniel Kokotajlo và William Saunders gần đây cũng rời công ty, trong khi Cullen O'Keefe, trưởng nhóm nghiên cứu về chính sách, đã thôi việc tại OpenAI từ tháng 4.

Kokotajlo chia sẻ với Vox rằng ông “dần mất niềm tin vào lãnh đạo và khả năng xử lý AGI (trí tuệ nhân tạo tổng hợp) một cách có trách nhiệm của công ty”.

Nhóm Superalignment do Leike và Sutskever đứng đầu với khoảng 20 thành viên vào năm ngoái, hiện đã giải thể. Đại diện OpenAI nói với The Information rằng công ty đã phân công số nhân viên còn lại vào nhóm nghiên cứu rộng hơn nhằm đáp ứng mục tiêu siêu liên kết.

Tất nhiên, OpenAI còn sở hữu một nhóm nghiên cứu khác tập trung vào vấn đề an toàn có tên “Preparedness”, nhưng việc nhiều nhân vật cấp cao từ chức không phải là dấu hiệu tốt đối với công ty hàng đầu trong lĩnh vực phát triển AI tiên tiến.

NHÂN VIÊN CŨ KHÔNG CÓ QUYỀN LÊN TIẾNG

Sự sụp đổ của đội an toàn AI là đòn giáng mạnh tới Sam Altman, người luôn cố gắng thể hiện ý thức về an toàn khi phát triển AI siêu thông minh. Một số chuyên gia cho rằng tuyên bố từ Leike đã làm giảm uy tín của Altman về chủ đề này.

Cuối tuần trước, Vox phản ánh các thỏa thuận không tiết lộ nghiêm ngặt khiến nhiều nhân viên cũ của OpenAI buộc phải im lặng trước nhiều thông tin.

Theo ghi nhận, thỏa thuận bao gồm điều khoản không được tiết lộ, công ty có thể lấy đi cổ phần của nhân viên nếu họ chỉ trích chủ cũ hoặc thậm chí thừa nhận rằng NDA tồn tại.

Sam Altman thừa nhận trong bài đăng X: "Đây là lỗi của tôi, là một trong số ít lần tôi thực sự cảm thấy xấu hổ khi điều hành OpenAI. Tôi không hề hay biết về vấn đề này và lẽ ra tôi phải ngăn chặn triệt để".

TẠM NGỪNG GIỌNG NÓI AI

Bất chấp nỗ lực của OpenAI nhằm ngăn chặn hỗn loạn, mọi chuyện dường như vẫn chưa kết thúc.

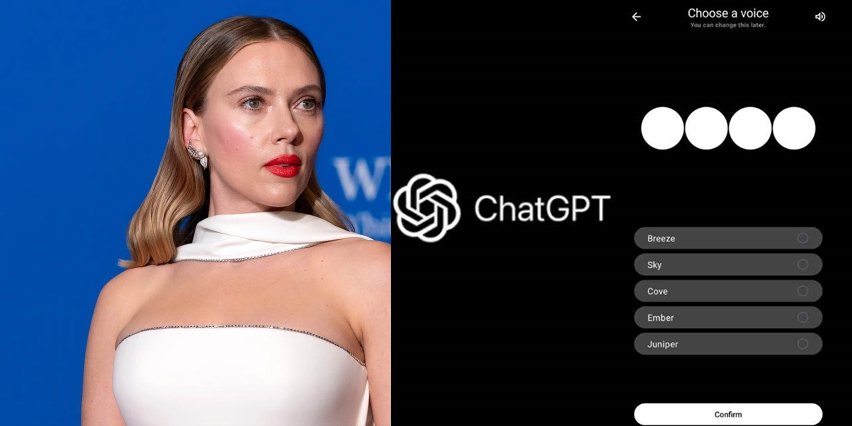

Đầu tuần này, công ty tuyên bố sẽ tạm dừng giọng nói "Sky" trong ChatGPT, gần đây được ví như giọng nói của nữ diễn viên nổi tiếng Scarlett Johansson.

Công ty khẳng định trong thông báo: “Chúng tôi tin rằng giọng nói AI không nên cố tình bắt chước giọng nói đặc biệt của người nổi tiếng. Giọng nói Sky không bắt chước Scarlett Johansson mà thuộc về một nữ diễn viên lồng tiếng chuyên nghiệp khác sử dụng giọng nói tự nhiên của chính cô ấy”.

Giọng nói, một phần quan trọng trong bản demo GPT-4o, được nhiều người so sánh với nhân vật trợ lý ảo do Scarlett Johansson đảm nhiệm trong bộ phim "Her". CEO Altman thậm chí cũng thừa nhận nhiều điểm tương đồng.

Ngoài ra, một số người dùng phàn nàn về giọng nói mới của chatbot, cho rằng nó quá gợi dục và mang dáng vẻ tán tỉnh trong các video demo lan truyền trên mạng.

Bỏ ngoài tai lời chỉ trích, OpenAI tỏ ra “đắc thắng” khi ra mắt phiên bản mới. Sam Altman còn không ngần ngại đề cập tới Google, công ty vừa giới thiệu bộ sản phẩm AI mạnh mẽ nhất tại Hội nghị Nhà phát triển thường niên.

“Tôi cố gắng không nghĩ về các đối thủ cạnh tranh quá nhiều, nhưng tôi không thể ngừng so sánh sự khác biệt về mặt thẩm mỹ giữa OpenAI và Google”, CEO Altman viết trên X, kèm theo hình ảnh bản demo của đối thủ.

OpenAI không trả lời ngay lập tức yêu cầu bình luận từ Business Insider về tình trạng hiện tại của công ty.

Khám phá vai trò của trí tuệ nhân tạo trong việc nâng cao hiệu quả và lợi thế cạnh tranh cho doanh nghiệp trong kỷ nguyên số.

Khám phá cách các công ty AI như OpenAI, Google đang cung cấp ưu đãi miễn phí để thu thập dữ liệu thực tế từ người tiêu dùng.

Khám phá cuộc chiến giữa chính phủ và Big Tech trong việc thu hút nhân tài công nghệ tại Singapore. Đọc ngay để hiểu rõ hơn!

Khám phá nguồn vốn khổng lồ và rủi ro trong cuộc đua xây dựng trung tâm dữ liệu AI của các big tech.

Khám phá sự thay đổi chính sách tiền điện tử tại châu Á, từ Trung Quốc đến Nhật Bản và Thái Lan. Đọc ngay để hiểu rõ hơn!

Nvidia sắp ra mắt chip AI mới cho Trung Quốc. Tìm hiểu về công nghệ và tiềm năng thị trường này ngay hôm nay!

Khám phá lý do 95% dự án AI doanh nghiệp thất bại và tìm hiểu giải pháp để thành công trong triển khai AI tạo sinh.

Khám phá cách AI đàm thoại giúp doanh nghiệp truy cập thông tin nhanh chóng và chính xác hơn. Tìm hiểu ngay!

Khám phá cách bảo vệ bản thân và gia đình trước hiểm họa bắt cóc online. Tìm hiểu ngay để tránh trở thành nạn nhân!

Chủ tịch Cisco cảnh báo rằng việc loại bỏ vị trí sơ cấp là sai lầm lớn trong kỷ nguyên AI. Đọc ngay để hiểu rõ hơn!