Điều gì có thể khiến Nvidia mất ‘ngôi vương’ ngành chip trí tuệ nhân tạo?

Mai Anh

22/05/2025

Triển vọng cho trí tuệ nhân tạo không lạc quan như kỳ vọng cùng sự nổi lên của các mô hình rẻ hơn với hiệu suất tương đương sẽ là bài toán Nvidia phải giải trong thời gian tới…

Sau một đợt tăng giá cổ phiếu bùng nổ đến mức từng giúp Nvidia trở thành công ty giá trị nhất thế giới, các nhà đầu tư giờ đây đã thận trọng hơn khi rót thêm tiền vào nhà sản xuất chip này. Họ hoàn toàn hiểu rằng, quá trình ứng dụng trí tuệ nhân tạo (AI) sẽ không diễn ra theo đường thẳng và cũng không thể chỉ dựa vào công nghệ của Nvidia.

Cho đến hiện tại, Nvidia vẫn là “người bán cuốc xẻng” hàng đầu trong cuộc đua “đào vàng” từ AI. Doanh thu của hãng tiếp tục tăng vọt và sổ đặt hàng cho dòng chip Hopper cùng thế hệ kế tiếp có tên Blackwell đang dày đặc.

Tác giả Ian King nhận định trên trang Bloomberg rằng, thành công của Nvidia trong thời gian tới phụ thuộc vào việc Microsoft, Google và các ông lớn công nghệ khác có thể tiếp tục kiếm lời sau các khoản đầu tư khổng lồ vào chip Nvidia để ra mắt các ứng dụng thương mại AI.

Thế nhưng ngay cả khi viễn cảnh đó trở thành hiện thực, không ai rõ sẽ cần đến bao nhiêu chip cao cấp của Nvidia để có được lợi nhuận trong bối cảnh mới. Sự xuất hiện mô hình AI từ Trung Quốc – DeepSeek – vào tháng 1 vừa qua với lời tuyên bố về công suất hoạt động ngang ngửa với các sản phẩm do các công ty Mỹ phát triển với mức tài nguyên tiêu tốn ít hơn mang đến thêm lựa chọn cho các gã khổng lồ công nghệ.

Bằng chứng là ngay sau khi DeepSeek công bố bài báo khoa học mô tả chi tiết khả năng của mô hình mới và cách thức phát triển, vốn hóa của Nvidia bốc hơi tới gần 590 tỷ USD – mức giảm giá trị lớn nhất trong ngày trong lịch sử hãng này.

Vậy điều gì đã khiến gã khổng lồ này có đà tăng trưởng ấn tượng suốt một thời gian dài và liệu rằng trong tương lai, điều gì có thể ngôi vương ấy sụp đổ?

VÌ SAO CHIP CỦA NVIDIA LẠI CẦN THIẾT ĐẾN VẬY?

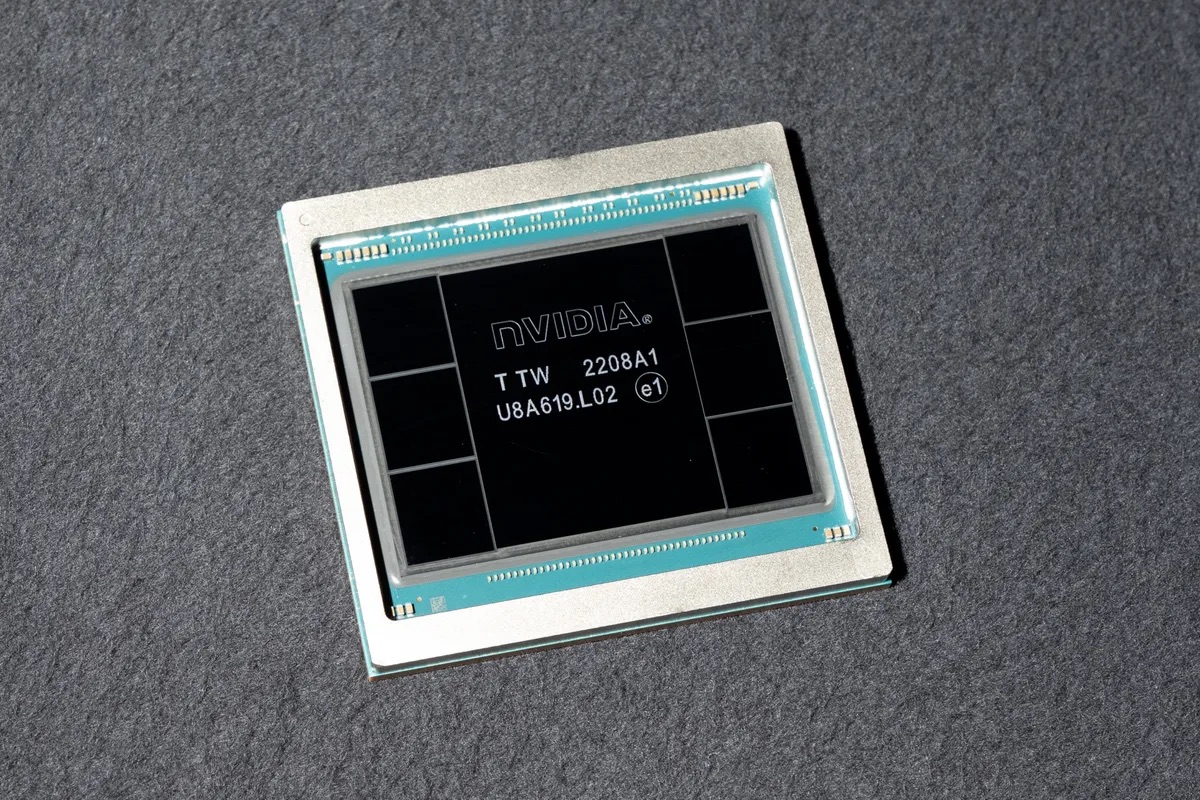

Theo Bloomberg, con chip kiếm tiền chủ lực hiện nay của Nvidia là Hopper H100, được đặt theo tên nữ tiên phong khoa học máy tính – bà Grace Hopper. Đây là phiên bản mạnh mẽ hơn của bộ xử lý đồ họa vốn bắt đầu từ máy tính cá nhân của các game thủ.

Dòng chip mới có tên Blackwell, lấy tên nhà toán học David Blackwell hiện đang dần nổi lên chiếm lấy vị trí đầu bảng.

Cả hai dòng chip này đều sở hữu công nghệ cho phép kết nối các cụm máy tính chạy chip Nvidia thành một thể thống nhất, giúp xử lý khối lượng dữ liệu khổng lồ và thực hiện các phép tính với tốc độ cực cao. Điều này khiến chúng trở thành lựa chọn hoàn hảo cho nhiệm vụ ngốn nhiều năng lượng: huấn luyện các mạng nơ-ron đứng sau thế hệ sản phẩm AI mới nhất.

Thành lập từ năm 1993, Nvidia đã tiên phong trong thị trường này với những khoản đầu tư từ hơn một thập kỷ trước, khi họ đặt cược rằng khả năng xử lý song song sẽ giúp chip của mình trở nên hữu dụng cho các lĩnh vực ngoài game.

Theo Nvidia, Blackwell có hiệu suất huấn luyện AI cao gấp 2,5 lần Hopper. Thiết kế mới có số lượng bóng bán dẫn – các công tắc tí hon giúp chất bán dẫn xử lý thông tin – nhiều đến mức không thể sản xuất theo kiểu đơn chip truyền thống. Thay vào đó, đây thực chất là hai con chip kết nối với nhau qua một hệ thống đảm bảo chúng hoạt động liền mạch như một thể thống nhất.

Với các khách hàng đang chạy đua để huấn luyện nền tảng AI thực hiện những tác vụ mới, lợi thế hiệu suất mà chip Hopper và Blackwell mang lại vô cùng quan trọng. Các thành phần này được xem là then chốt đến mức chính phủ Mỹ phải áp đặt hạn chế bán cho Trung Quốc.

ĐIỀU GÌ ĐÃ GIÚP NVIDIA THỐNG TRỊ CHIP AI?

Nvidia vốn là ông trùm thị trường chip đồ họa – những bộ xử lý tạo ra hình ảnh hiển thị trên màn hình máy tính. Các chip mạnh nhất trong số này được trang bị hàng ngàn lõi xử lý, có thể thực hiện đồng thời nhiều luồng tác vụ, giúp dựng nên các hiệu ứng 3D phức tạp như bóng đổ hay phản chiếu trong game hiện đại.

Đầu những năm 2000, các kỹ sư của Nvidia nhận ra họ có thể điều chỉnh các bộ tăng tốc đồ họa này cho các ứng dụng khác. Cùng lúc đó, các nhà nghiên cứu AI cũng phát hiện rằng loại chip này có thể biến lý thuyết của họ thành hiện thực.

Theo hãng nghiên cứu thị trường IDC, Nvidia đang kiểm soát khoảng 90% thị phần GPU trung tâm dữ liệu. Các nhà cung cấp dịch vụ điện toán đám mây lớn như AWS của Amazon, Google Cloud của Alphabet và Azure của Microsoft – cũng đồng thời là khách hàng lớn của Nvidia – đang tìm cách phát triển chip riêng, tương tự như các đối thủ khác của Nvidia gồm Advanced Micro Devices và Intel.

Tuy nhiên, đến thời điểm này, những nỗ lực phát triển chip thay thế vẫn chưa đủ sức làm suy yếu vị thế thống trị của Nvidia.

Điều giúp cho Nvidia duy trì được vị thế dẫn đầu là việc liên tục nâng cấp các dòng sản phẩm, bao gồm cả phần mềm hỗ trợ phần cứng với tốc độ chưa một công ty nào có thể bắt kịp. Hãng còn thiết kế các hệ thống cụm (cluster systems) giúp khách hàng mua số lượng lớn chip H100 và triển khai nhanh chóng.

Các dòng chip như bộ xử lý Xeon của Intel cũng đủ khả năng xử lý dữ liệu phức tạp, nhưng chúng lại có số lõi ít hơn và tốc độ xử lý các tập dữ liệu khổng lồ thường dùng để huấn luyện phần mềm AI cũng chậm hơn.

Intel – từng là nhà cung cấp linh kiện trung tâm dữ liệu số một – đến nay vẫn gặp khó khăn trong việc tung ra các bộ tăng tốc mà khách hàng sẵn sàng lựa chọn thay cho thiết bị của Nvidia.

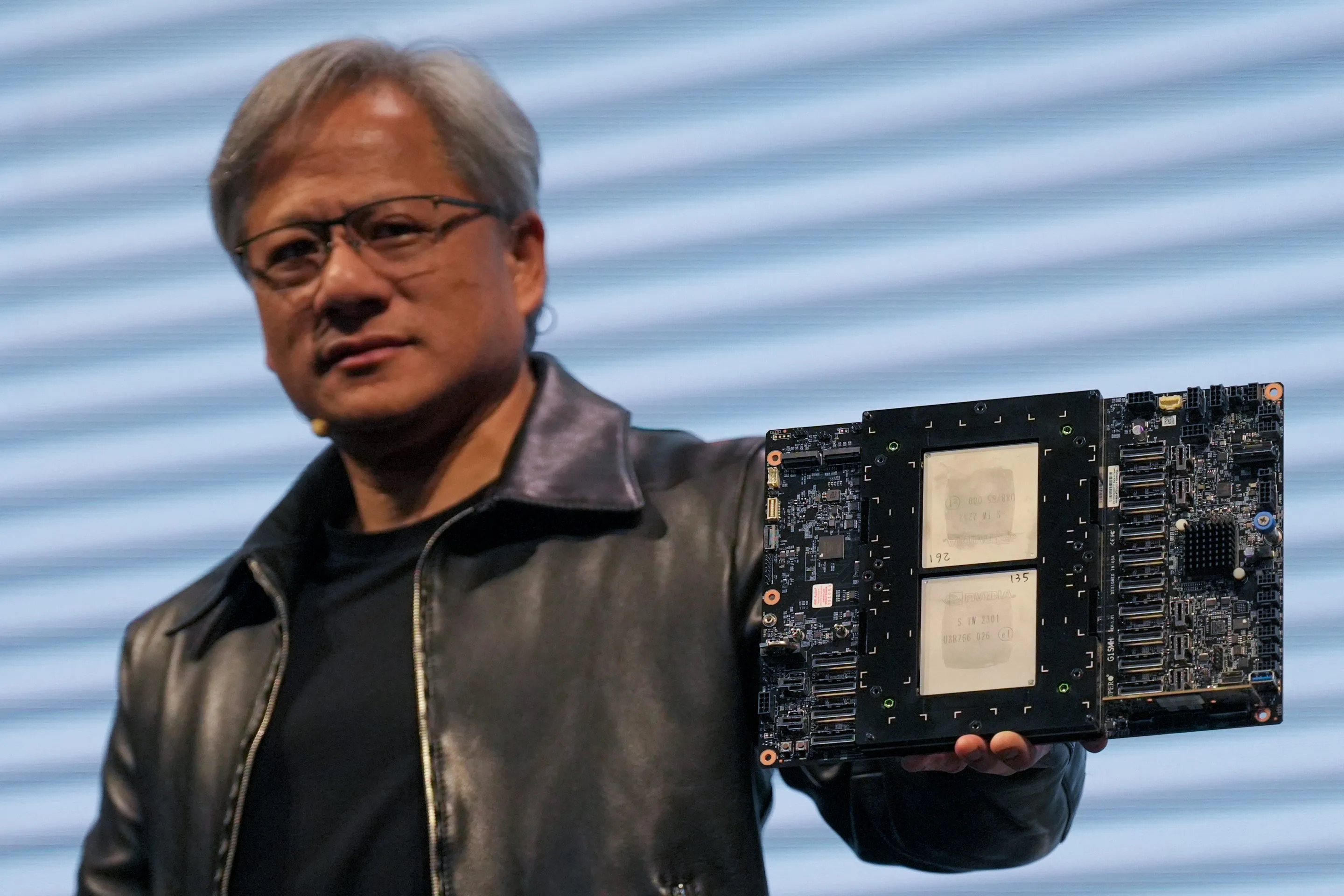

Huang và nhóm của ông đã nhiều lần nói rằng công ty có nhiều đơn đặt hàng hơn mức có thể đáp ứng, ngay cả đối với các mẫu cũ hơn.

Microsoft, Amazon, Meta Platforms Inc. và Google đã công bố kế hoạch chi hàng trăm tỷ đô la cho AI và các trung tâm dữ liệu để hỗ trợ AI. Gần đây hơn, có suy đoán rằng sự bùng nổ của trung tâm dữ liệu AI đã mất đà. Microsoft đã rút lui khỏi các dự án trung tâm dữ liệu trên toàn thế giới, làm dấy lên mối lo ngại rộng rãi hơn về việc liệu công ty có đảm bảo được nhiều năng lực tính toán AI hơn mức cần thiết trong dài hạn hay không.

Theo Bloomberg, ông Jensen Huang – CEO của Nvidia từng nhiều lần cho biết, số lượng đơn đặt hàng nhiều hơn mức công ty có thể đáp ứng, ngay cả đối với các dòng chip cũ.

Microsoft, Amazon, Meta Platforms và Google đã công bố kế hoạch chi hàng trăm tỷ đô la cho AI và các trung tâm dữ liệu để hỗ trợ AI. Tuy vậy gần đây, sự bùng nổ của trung tâm dữ liệu AI được đồn đoán là đã mất đà khi Microsoft rút lui khỏi các dự án trung tâm dữ liệu trên toàn thế giới, làm dấy lên mối lo ngại về việc liệu rằng Nvidia có đang tạo ra nhiều năng lực tính toán AI hơn mức cần thiết trong dài hạn hay không.

MỐI NGUY TỪ TRUNG QUỐC?

Tháng 1 vừa qua, mô hình AI mã nguồn mở R1 của DeepSeek được công bố, đặt ra câu hỏi vì sao một doanh nghiệp khởi nghiệp non trẻ của Trung Quốc lại có thể đạt được kết quả ngang ngửa với các công ty Mỹ với nguồn lực đào tạo ít hơn nhiều.

DeepSeek đã tinh chỉnh mô hình AI bằng dữ liệu thực tế, một phương pháp được gọi là “inference” – suy diễn – ít tốn thời gian và dữ liệu hơn nhiều so với phương pháp huấn luyện nhân tạo mà các công ty khác đang sử dụng.

Nvidia, có lẽ là bên chịu ảnh hưởng nhiều nhất, đã phải thừa nhận rằng mô hình của DeepSeek là một “bước tiến AI xuất sắc”. Thậm chí, các kết quả đạt được không hề vi phạm các quy định kiểm soát xuất khẩu công nghệ của Mỹ.

Dù vậy, Nvidia vẫn khẳng định chip của họ vẫn sẽ tiếp tục đóng vai trò quan trọng, kể cả khi cách xây dựng các mô hình AI có thay đổi. “Việc inference cũng cần đến số lượng lớn GPU Nvidia và hệ thống mạng tốc độ cao”, công ty cho biết.

Các nhà sản xuất chip khác như AMD, nhà sản xuất chip đồ họa máy tính lớn thứ hai thế giới, hay Intel đã tung ra các dòng chip cải tiến, nhưng cho đến này, chưa có doanh nghiệp này có thể tính đến việc đánh bại dòng chip Blackwell.

Lợi thế của Nvidia không chỉ nằm ở hiệu suất của phần cứng mà còn nằm ở CUDA, một ngôn ngữ cho chip đồ họa của hãng, cho phép việc lập trình các công việc hỗ trợ ứng dụng AI. Việc sử dụng rộng rãi công cụ phần mềm đó đã giúp ngành công nghiệp AI gắn chặt với phần cứng của Nvidia.

TÌM "MỎ VÀNG" MỚI GIỮA TRIỂN VỌNG BẤT ỔN

Theo tờ Financial Times, Nvidia đang tìm cách giảm bớt sự phụ thuộc vào các công ty công nghệ lớn tại Thung lũng Silicon bằng việc ký kết nhiều thỏa thuận hợp tác mới về việc bán các loại chip trí tuệ nhân tạo (AI) cho các quốc gia, các doanh nghiệp và thậm chí là các đối thủ của Microsoft, Amazon và Google trong mảng điện toán đám mây.

Theo đó, Nvidia đã hợp tác với những doanh nghiệp như CoreWeave, Nebius, Crusoe và Lambda thành một phần trong mạng lưới “Đối tác đám mây Nvidia”.

Trong vài tháng gần đây, Nvidia cũng đã thiết lập liên minh với các nhà cung cấp như Cisco, Dell và HP để hỗ trợ bán hàng cho các khách hàng doanh nghiệp – những tổ chức tự vận hành cơ sở hạ tầng công nghệ thông tin thay vì chuyển dịch lên điện toán đám mây.

Không chỉ vậy, gã khổng lồ chip của Mỹ mới đây đã công bố một thỏa thuận chip trị giá hàng tỷ USD với công ty Humain của Ả Rập Xê Út. Những thỏa thuận về AI có chủ quyền (hệ thống AI được phát triển, sở hữu và kiểm soát bởi một quốc gia hay chính phủ) này là một phần quan trọng trong chiến lược tiếp cận khách hàng ngoài Thung lũng Silicon của Nvidia.

Các lãnh đạo Nvidia cho biết thêm, họ đã nhận được đề nghị từ nhiều chính phủ khác muốn mua chip của hãng cho các dự án AI có chủ quyền tương tự, điều có giúp doanh nghiệp này có thêm hàng tỷ USD doanh thu mỗi năm.

Malaysia công bố bộ xử lý AI đầu tiên, khẳng định vị thế trong chuỗi cung ứng chip toàn cầu. Tìm hiểu thêm về bước tiến này!

Khám phá kế hoạch của Trung Quốc trong việc tăng sản lượng chip AI gấp ba lần vào năm tới để cạnh tranh với các đối thủ phương Tây.

Khám phá sự bùng nổ trong ngành sản xuất chip và máy chủ Trung Quốc nhờ AI. Đầu tư hàng tỷ USD đang thay đổi cục diện công nghệ.

Chiến lược sản xuất iPhone tại Ấn Độ của Apple gặp khó khăn do triệu hồi kỹ sư Trung Quốc. Tìm hiểu nguyên nhân và tác động ngay!

Khám phá cách các gã khổng lồ công nghệ như Meta, Google, Tesla tái sinh tinh thần startup trong cuộc đua AI.

Khám phá vai trò của trí tuệ nhân tạo trong việc nâng cao hiệu quả và lợi thế cạnh tranh cho doanh nghiệp trong kỷ nguyên số.

Khám phá cách các công ty AI như OpenAI, Google đang cung cấp ưu đãi miễn phí để thu thập dữ liệu thực tế từ người tiêu dùng.

Khám phá cuộc chiến giữa chính phủ và Big Tech trong việc thu hút nhân tài công nghệ tại Singapore. Đọc ngay để hiểu rõ hơn!

Khám phá nguồn vốn khổng lồ và rủi ro trong cuộc đua xây dựng trung tâm dữ liệu AI của các big tech.

Khám phá sự thay đổi chính sách tiền điện tử tại châu Á, từ Trung Quốc đến Nhật Bản và Thái Lan. Đọc ngay để hiểu rõ hơn!