Doanh nghiệp có thêm lựa chọn giải pháp thiết bị AI tại chỗ

Hoàng An

08/01/2025

Các doanh nghiệp vừa và nhỏ, các tập đoàn và tổ chức công nghiệp giờ đây có thể triển khai các ứng dụng AI tùy chỉnh hoặc có sẵn ngay trên hạ tầng nội bộ, bao gồm cả tác vụ tạo sinh nội dung mới, đảm bảo các dữ liệu nhạy cảm của khách hàng…

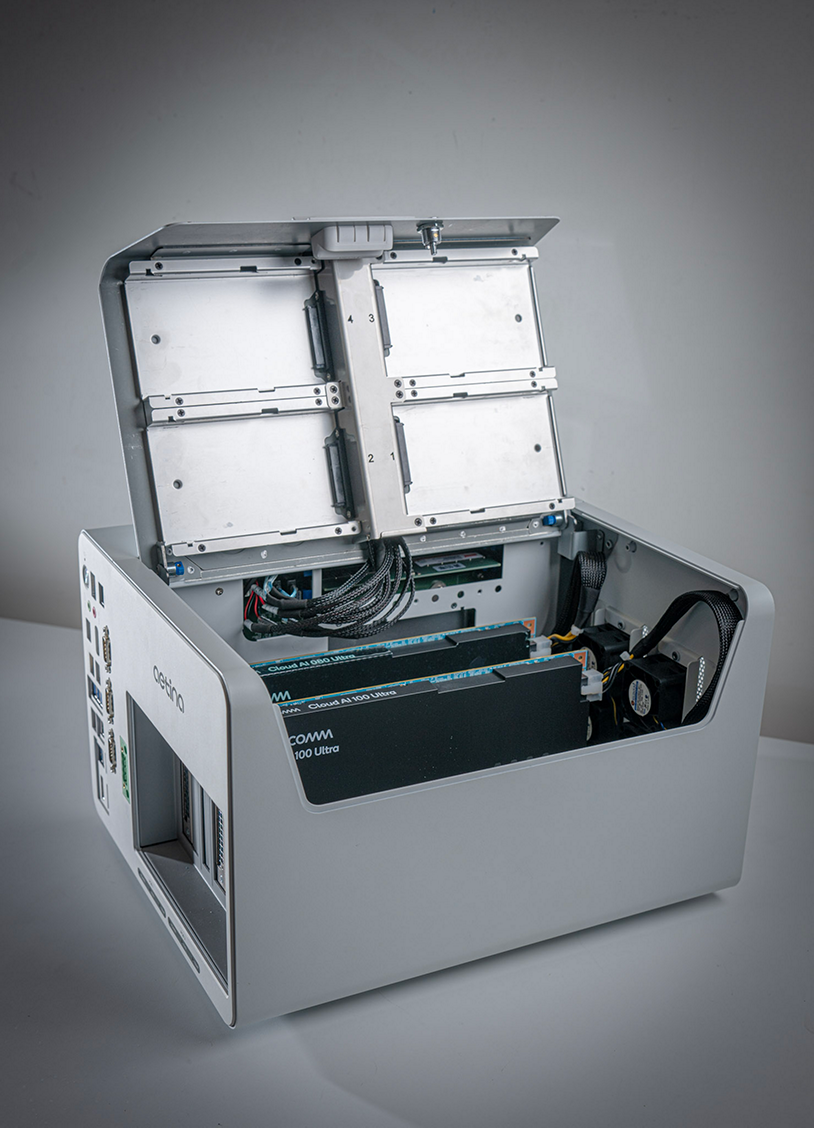

Tại sự kiện CES 2025, Qualcomm Technologies, Inc. đã công bố Qualcomm® AI On-Prem Appliance Solution (Giải pháp triển khai AI tại chỗ…) – Giải pháp phần cứng chuyên dụng để bàn hoặc gắn lên tường – và Qualcomm® Cloud AI Inference Suite (Bộ công cụ suy luận AI với Qualcomm® Cloud) – bao gồm các phần mềm, dịch vụ hỗ trợ suy luận AI từ môi trường cận biên (near-edge) đến đám mây (cloud).

Sự kết hợp này cho phép các doanh nghiệp vừa và nhỏ, các tập đoàn và tổ chức công nghiệp triển khai các ứng dụng AI tùy chỉnh hoặc có sẵn ngay trên hạ tầng nội bộ, bao gồm cả tác vụ tạo sinh nội dung mới. Việc chạy suy luận AI trên cơ sở hạ tầng nội bộ giúp tiết kiệm đáng kể về mặt chi phí vận hành và tổng chi phí sở hữu (TCO) so với việc thuê hạ tầng AI từ bên thứ ba.

THAY ĐỔI TỔNG CHI PHÍ SỞ HỮU (TCO) KHI TRIỂN KHAI AI

Khi sử dụng kết hợp Giải pháp triển khai AI tại chộ̃ và Bộ công cụ suy luận AI, người dùng giờ đây có thể tận dụng AI tạo sinh dựa trên dữ liệu độc quyền, các mô hình được tinh chỉnh và hạ tầng công nghệ của họ để tự động hóa các quy trình của con người lẫn máy móc trong hầu hết mọi môi trường cuối như cửa hàng bán lẻ, nhà hàng phục vụ nhanh, trung tâm mua sắm, bệnh viện, đại lý ô tô, nhà máy và xưởng sản xuất – những nơi mà quy trình làm việc đã được thiết lập sẵn, có các thao tác mang tính lặp lại và sẵn sàng cho tự động hóa.

Ông Nakul Duggal, Tổng giám đốc mảng Ô tô, Công nghiệp và Điện toán tại Qualcomm Technologies, Inc. cho biết, giải pháp thiết bị AI cục bộ và Bộ Công cụ Cloud AI Inference Suite sẽ thay đổi tổng chi phí sở hữu (TCO) khi triển khai AI bằng cách cho phép chuyển khối lượng công việc liên quan đến thao tác xử lý AI tạo sinh từ đám mây sang triển khai tại chỗ, ngay trên cơ sở hạ tầng nội bộ.

“Với nhiều trường hợp sử dụng tự động hóa AI như trợ lý hỗ trợ ở cửa hàng, đào tạo nhân viên, xử lý thông tin theo địa điểm cụ thể, tuân thủ quy định đảm bảo an toàn cũng như hỗ trợ bán sản phẩm, dịch vụ tại cửa hàng, đại lý hay nhà máy, Giải pháp triển khai AI cục bộ giúp giảm đáng kể chi phí vận hành AI theo nhu cầu của doanh nghiệp và ngành công nghiệp”, ông Nakul Duggal nói. “Các doanh nghiệp giờ đây có thể đẩy nhanh việc triển khai các ứng dụng AI tạo sinh bằng cách tận dụng những mô hình riêng của họ, với quyền riêng tư, cá nhân hóa và tùy chỉnh, trong khi vẫn kiểm soát hoàn toàn và đảm bảo rằng dữ liệu không bị rò rỉ khỏi cơ sở hạ tầng nội bộ”.

Giải pháp Qualcomm AI On-Prem Appliance được trang bị bộ tăng tốc Qualcomm® Cloud AI, kết hợp khả năng truy cập và hiệu suất của máy chủ suy luận trong trung tâm dữ liệu với hiệu quả về năng lượng, trọng lượng, thiết kế, tính bảo mật dữ liệu, cá nhân hóa và quyền kiểm soát của một giải pháp AI triển khai cục bộ. Giải pháp AI On-Prem Appliance hỗ trợ đa dạng tính năng bao gồm:

Thứ nhất là tính năng mở rộng từ một chiếc máy tính để bàn thành một cụm thiết bị có thể gắn lên tường, cung cấp nhiều dịch vụ AI cục bộ như trợ lý giọng nói tích hợp, xử lý mô hình ngôn ngữ nhỏ (SLM), mô hình ngôn ngữ lớn (LLM) và mô hình đa phương thức lớn (LMM) cùng với các chức năng tạo tăng cường truy xuất (RAG) để tìm kiếm thông minh theo chỉ mục và tóm tắt, chuyển giao các nhiệm vụ phức tạp để AI có khả năng tự chủ nhất định (agentic AI), tự động hóa quy trình làm việc của AI, tạo hình ảnh, tạo mã, thị giác máy tính và xử lý camera.

Thứ hai là hỗ trợ đa dạng mô hình AI tạo sinh, xử lý ngôn ngữ tự nhiên và các mô hình thị giác máy tính (bao gồm cả mã nguồn mở lẫn độc quyền) để tự động hóa quy trình làm việc cho các ứng dụng doanh nghiệp như tìm kiếm đa ngôn ngữ thông minh, trợ lý AI tùy chỉnh, tạo mã, ghi chép tự động và nhiều ứng dụng khác.

Thứ ba là camera AI hỗ trợ xử lý hình ảnh, video và truyền dữ liệu (streaming) cho các ứng dụng thị giác máy tính tập trung vào tính bảo mật, an toàn và giám sát địa điểm.

THIẾT BỊ AI TRIỂN KHAI CỤC BỘ NHỎ GỌN, CHẠY BẰNG NGUỒN ĐIỆN THƯỜNG

Bộ công cụ Qualcomm Cloud AI Inference Suite cung cấp cho khách hàng doanh nghiệp và các nhà phát triển bên thứ ba một bộ công cụ và thư viện toàn diện để họ phát triển hoặc chuyển đổi ứng dụng AI tạo sinh sang Giải pháp triển khai AI cục bộ hoặc các giải pháp khác dựa trên bộ tăng tốc AI Qualcomm Cloud.

Bộ công cụ này bao gồm các giao diện lập trình ứng dụng (API) phong phú để hỗ trợ quản lý người dùng, trò chuyện, tạo hình ảnh, âm thanh và video, tương thích với OpenAI API, và tăng cường truy xuất (RAG). Bộ công cụ cũng hỗ trợ tích hợp các mô hình AI tạo sinh và các framework phổ biến, triển khai thông qua nền tảng quản lý và điều phối các ứng dụng Kubernetes hoặc một bộ chứa (container) đơn giản.

Những thiết bị AI triển khai cục bộ nhỏ gọn, chạy bằng nguồn điện thường từ ổ cắm trên tường này kết hợp các mô hình ngôn ngữ nhỏ (SLMs) với khả năng xử lý ngôn ngữ tự nhiên cùng với các mô hình ngôn ngữ lớn (LLMs) và mô hình đa phương thức lớn (LMMs) đã được tinh chỉnh (từ 70 tỷ tham số trở lên) để vận hành các tác nhân AI (AI agent) cho doanh nghiệp.

Các tác nhân này hỗ trợ phản hồi theo thời gian thực và tự động hóa quy trình làm việc AI, chẳng hạn như tìm kiếm thông minh với nội dung được lập chỉ mục và tạo nội dung – tất cả đều được thực hiện với mức tiêu thụ năng lượng tối ưu, vượt trội so với tổng chi phí sở hữu.

Vì sao ngành công nghệ sinh học Trung Quốc đang thu hút sự chú ý toàn cầu? Khám phá những thỏa thuận kỷ lục và tiềm năng phát triển trong tương lai.

Khám phá sự mơ hồ xung quanh AGI và tác động của nó đến tương lai công nghệ. Liệu AGI có thể thay đổi cuộc sống con người trong thập kỷ tới?

Golden Communication Group, doanh nghiệp Việt duy nhất, nhận giải thưởng ZeroDX 2025, khẳng định vị thế toàn cầu bên GE và Bayer.

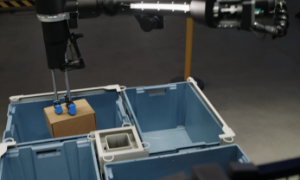

Amazon giới thiệu robot Blue Jay mới, tự động hóa quy trình kho hàng, tăng hiệu suất và tiết kiệm không gian.

Các nhà khoa học Trung Quốc công bố phát hiện quan trọng trong vật liệu quang khắc, mở đường cho tự chủ công nghệ bán dẫn.

Đại hội Đảng bộ TP Hà Nội lần thứ XVIII ứng dụng nền tảng iCabinet, đánh dấu bước tiến số trong tổ chức chính trị.

Khám phá những đột phá của Mirror Me trong ngành robot, từ tốc độ đến trí tuệ hiện thân. Đọc ngay để tìm hiểu thêm!