Liệu ngành chip toàn cầu sẽ có cuộc đua giành vị thế giữa Google và Nvidia?

Mai Anh

29/11/2025

Thương vụ mới nhất liên quan đến chip của Google đang đặt ra câu hỏi về việc chip Nvidia có thể bị thay thế hay không?…

Thông tin từ tờ The Wall Street Journal ngày 25/11 cho biết, Meta đang đàm phán để sử dụng chip do Google sản xuất trong hoạt động trí tuệ nhân tạo của hãng này, theo những người am hiểu sự việc.

Đây được đánh giá là một bước đi nhằm giảm bớt sự phụ thuộc vào Nvidia.

Một thỏa thuận có thể trị giá hàng tỷ USD, nhưng các cuộc đàm phán vẫn đang diễn ra và có thể không đi đến kết quả cuối cùng.

Hiện vẫn chưa rõ Meta sẽ sử dụng loại chip này – gọi là bộ xử lý tensor (TPU) – để huấn luyện mô hình AI hay để thực hiện việc suy luận, một nguồn tin cho biết. Suy luận, tức quá trình mô hình đã được huấn luyện dùng để tạo ra phản hồi cho truy vấn, đòi hỏi ít năng lực tính toán hơn so với huấn luyện.

Google đã dành nhiều năm để hoàn thiện chip riêng và mở rộng hoạt động kinh doanh loại này. Một thỏa thuận lớn với Meta sẽ là dấu hiệu rạn nứt đầu tiên trong sự thống trị thị trường của Nvidia, cũng là cơ hội để Google và các hãng chip khác khai thác.

“Câu chuyện lớn nhất trong AI lúc này là Google và Nvidia đang cạnh tranh cực kỳ quyết liệt”, ông Adam Sullivan, Giám đốc điều hành Nhà vận hành trung tâm dữ liệu Core Scientific, nói. “Họ (Google và Nvidia) đang chạy đua để giành càng nhiều năng lực trung tâm dữ liệu càng tốt”.

SỰ KHÁC BIỆT GIỮA GPU VÀ TPU?

GPU (Graphics Processing Unit – Bộ xử lý đồ họa) là một bộ vi xử lý chuyên dụng dùng để xử lý và tạo ra hình ảnh hiển thị trên màn hình. Google cho biết, TPU (Tensor Processing Unit – Bộ xử lý tensor) là một mạch tích hợp dành riêng cho ứng dụng nhằm tăng tốc các tính toán và thuật toán AI.

Theo Bloomberg, cả hai loại chip đều có thể xử lý lượng tính toán lớn liên quan đến huấn luyện mô hình AI, nhưng cách thực hiện khác nhau.

GPU của Nvidia ban đầu được phát triển để tạo hình ảnh trò chơi chân thực, xử lý nhiều tác vụ song song thông qua hàng nghìn lõi tính toán. Kiến trúc này cho phép xử lý các tác vụ AI với tốc độ mà công nghệ đối thủ khó sánh kịp.

Trong khi đó, TPU được xây dựng chuyên biệt cho loại tác vụ AI gọi là nhân ma trận – vốn là phép toán chính trong việc huấn luyện các mạng nơ-ron tạo phản hồi cho các chatbot như ChatGPT của OpenAI hay Claude của Anthropic. Phần lớn công việc này gồm các phép tính lặp đi lặp lại theo trình tự chứ không song song.

TPU được phát triển để thực hiện hiệu quả những tác vụ đó. Vì vậy, loại chip này được xem là kém linh hoạt và mang tính chuyên dụng hơn GPU Nvidia, nhưng lại tiết kiệm năng lượng hơn khi chạy các phép toán này.

Bên cạnh đó, GPU Nvidia linh hoạt và dễ lập trình hơn, nhưng sự linh hoạt đó khiến chi phí vận hành cao hơn.

TPU DẦN NỔI LÊN NHƯ THẾ NÀO?

Theo thông tin từ Bloomberg, Google bắt đầu phát triển TPU đầu tiên vào năm 2013 và công bố hai năm sau đó. Ban đầu, TPU này được sử dụng để tăng tốc công cụ tìm kiếm và cải thiện hiệu suất. Sau đó, Google bắt đầu đưa TPU lên nền tảng đám mây vào năm 2018.

CNBC cho biết thêm, không giống như Nvidia, Google không bán chip của hãng dưới dạng phần cứng, mà cung cấp quyền truy cập vào TPU dưới dạng dịch vụ thông qua đám mây. Dịch vụ này vốn đã trở thành một trong những động lực tăng trưởng lớn của công ty.

Những con chip này cũng được điều chỉnh để hỗ trợ hoạt động phát triển AI nội bộ của Google. Khi công ty và đơn vị trí tuệ nhân tạo DeepMind xây dựng các mô hình AI tiên tiến như Gemini, họ có thể mang những bài học từ đội ngũ AI quay lại cho các kỹ sư thiết kế TPU, từ đó tối ưu chip để phục vụ chính các nhóm phát triển AI trong công ty.

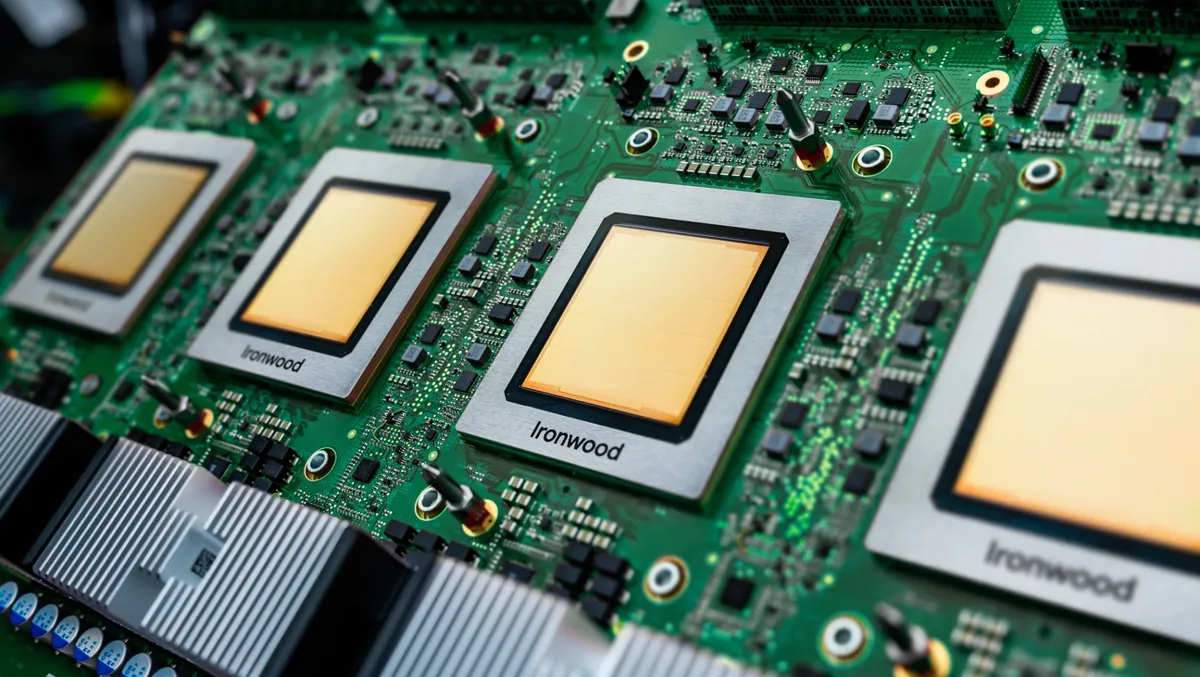

Phiên bản mới nhất của TPU, mang tên Ironwood, được công bố vào tháng 4. Chip này dùng hệ thống làm mát bằng chất lỏng và được thiết kế cho các tác vụ suy luận AI – nghĩa là sử dụng mô hình AI chứ không phải huấn luyện. Ironwood có hai cấu hình: một cụm gồm 256 chip và một cụm lớn hơn gồm 9.216 chip.

TPU có thể vượt GPU trong một số tác vụ AI vì Google có thể đã lược bỏ nhiều phần của chip không phục vụ AI. Ở thế hệ thứ bảy, Google đã nâng cao hiệu năng chip, tăng sức mạnh và giảm lượng năng lượng tiêu thụ, giúp chi phí vận hành thấp hơn.

Google không công bố quy mô hoạt động kinh doanh TPU trong phân khúc đám mây. Các nhà phân tích tại D.A. Davidson ước tính vào tháng 9 rằng, một doanh nghiệp độc lập bao gồm TPU và bộ phận AI DeepMind của Google có thể được định giá khoảng 900 tỷ USD, tăng so với ước tính 717 tỷ đô la vào tháng 1/2025.

TRIỂN VỌNG BÁN TPU TRONG TƯƠNG LAI NHƯ THẾ NÀO?

Hiện tại, doanh nghiệp muốn dùng TPU phải thuê năng lực tính toán trên đám mây của Google. Tuy nhiên, theo Bloomberg, điều này có thể sớm thay đổi.

CNBC cho biết, cuối tháng 10 vừa qua, thỏa thuận TPU lớn nhất từ trước đến nay của Google đã được ký kết khi công ty công bố việc mở rộng thỏa thuận với Anthropic – đối thủ của OpenAI với giá trị lên tới hàng chục tỷ đô la. Với mối quan hệ đối tác này, Google dự kiến sẽ đưa hơn 1GW năng lực tính toán AI lên mạng vào năm 2026.

Thỏa thuận với Anthropic khiến khả năng mở rộng TPU sang các nền tảng đám mây khác trở nên thực tế hơn, theo các nhà phân tích của Bloomberg Intelligence.

Dù vậy, các nhà phân tích cũng lưu ý rằng, không ai, kể cả Google, tìm cách thay thế hoàn toàn GPU Nvidia. Nguyên nhân đơn giản là tốc độ phát triển AI hiện nay khiến viễn cảnh đó chưa thể xảy ra.

Google vẫn là một trong những khách hàng lớn nhất của Nvidia dù có chip riêng, vì hãng buộc phải giữ sự linh hoạt cho khách hàng, theo ông Gaurav Gupta, nhà phân tích tại Gartner. Nếu thuật toán hoặc mô hình của khách hàng thay đổi, GPU phù hợp hơn để xử lý nhiều dạng tác vụ.

Thậm chí, ngay cả các công ty đang chọn TPU cũng vẫn cam kết mạnh mẽ với chip Nvidia. Anthropic, chẳng hạn, đã công bố một thỏa thuận lớn với Nvidia chỉ vài tuần sau hợp tác TPU với Google. Hy vọng lớn nhất cho TPU của Google có thể chỉ dừng lại là một phần trong “rổ công nghệ” cần thiết để vận hành sự tăng trưởng của AI.

Nvidia đang thiết kế một hệ thống xử lý mới chuyên biệt cho inference, dự kiến công bố tại hội nghị nhà phát triển GTC ở San Jose trong tháng này...

Nhà đầu tư gần đây tỏ ra lo ngại rằng làn sóng chi tiêu khổng lồ cho phần cứng AI có thể không bền vững…

Chiến lược này phản ánh cách tiếp cận mới của Nhật Bản: thay vì phát triển đơn lẻ, Tokyo chọn cách xây dựng hạ tầng dùng chung, khuyến khích hợp tác công – tư và mở rộng liên kết quốc tế...

Từ các startup vài trăm người đến những gã khổng lồ như Amazon, Google, Meta, Microsoft hay Salesforce, trí tuệ nhân tạo (AI) không còn là công cụ tùy chọn nữa …

AI giúp doanh nghiệp sở hữu đội ngũ nhân viên ở mức tối thiểu nhưng việc tinh gọn cũng che lấp nhiều cơ hội kinh doanh…

Các câu trả lời từ chatbot giờ đây không chỉ đơn thuần phục vụ cho mục đích cá nhân mà còn trở thành một công cụ điều hướng người dùng mới của các doanh nghiệp…

Thỏa thuận mua 6 gigawatt năng lực tính toán AI từ AMD không chỉ mang lại hợp đồng trị giá hơn 100 tỷ USD, mà còn có thể giúp Meta sở hữu tới 10% cổ phần của nhà sản xuất chip...

ByteDance quyết tâm đẩy mạnh AI khi chatbot Doubao vượt mốc 100 triệu người dùng…

Viễn cảnh robot vượt số lao động có thể không chỉ là dự báo mà trở thành hiện thực kinh tế trong vài thập kỷ tới...

Doanh thu và lợi nhuận đồng loạt tăng hai chữ số, đơn hàng giao sớm dồn dập, trong khi thị trường Trung Quốc tiếp tục là điểm nóng giữa bối cảnh kiểm soát xuất khẩu ngày càng siết chặt...