Microsoft là khách hàng chip AI lớn nhất của Nvidia

Thanh Minh, Huyền Thương, Hoàng

26/12/2024

Lượng chip khổng lồ mà Microsoft sở hữu đã mang lại lợi thế lớn trong cuộc đua xây dựng thế hệ hệ thống AI tiếp theo...

Microsoft đã mua số lượng chip Nvidia “Hopper” nhiều gấp đôi so với bất kỳ đối thủ lớn nào tại Mỹ và Trung Quốc trong năm 2024, khi nhà đầu tư lớn nhất của OpenAI tăng tốc đầu tư vào hạ tầng trí tuệ nhân tạo (AI).

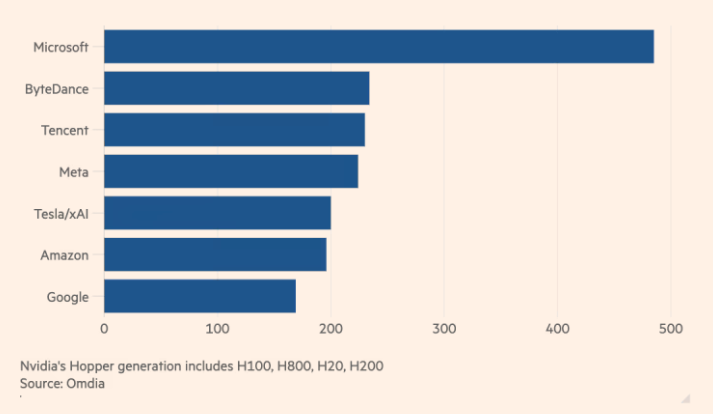

Theo ước tính từ Omdia, một công ty tư vấn công nghệ, Microsoft đã mua 485.000 chip “Hopper” của Nvidia trong năm nay. Con số này vượt xa Meta – khách hàng lớn thứ hai của Nvidia tại Mỹ, với 224.000 chip, cũng như các đối thủ Amazon và Google trong mảng điện toán đám mây.

Trong hai năm qua, nhu cầu vượt xa nguồn cung đối với các bộ xử lý đồ họa tiên tiến nhất của Nvidia. Lượng chip khổng lồ mà Microsoft sở hữu đã mang lại lợi thế lớn trong cuộc đua xây dựng thế hệ hệ thống AI tiếp theo.

BIG TECH ĐẦU TƯ MẠNH VÀO TRUNG TÂM DỮ LIỆU VÀ HỆ THỐNG AI

Năm nay, các công ty công nghệ lớn đã chi hàng chục tỷ USD để xây dựng trung tâm dữ liệu sử dụng chip mới nhất của Nvidia, vốn trở thành mặt hàng nóng nhất tại Silicon Valley kể từ khi ChatGPT ra mắt hai năm trước, khơi mào làn sóng đầu tư chưa từng có vào AI.

Hạ tầng đám mây Azure của Microsoft được sử dụng để đào tạo mô hình GPT-4 mới nhất của OpenAI, trong bối cảnh Microsoft cạnh tranh với Google, các startup như Anthropic và xAI của Elon Musk, cũng như các đối thủ tại Trung Quốc để giành vị trí dẫn đầu trong thế hệ điện toán mới.

Omdia ước tính ByteDance và Tencent mỗi công ty đã đặt mua khoảng 230.000 chip Nvidia trong năm nay, bao gồm cả mẫu H20 – phiên bản yếu hơn của Hopper được sửa đổi để tuân thủ các quy định xuất khẩu của Mỹ đối với khách hàng Trung Quốc.

Amazon và Google, hai đối thủ đang tăng cường triển khai chip AI tùy chỉnh của riêng mình thay thế cho Nvidia, lần lượt mua 196.000 và 169.000 chip Hopper, theo Omdia.

Giá trị của Nvidia, hiện đang triển khai thế hệ chip kế nhiệm Hopper mang tên Blackwell, đã tăng vọt lên hơn 3.000 tỷ USD trong năm nay, khi các công ty công nghệ lớn đổ xô lắp đặt cụm GPU khổng lồ của hãng. Tuy nhiên, đà tăng trưởng phi thường của cổ phiếu Nvidia đã chững lại trong những tháng gần đây, do lo ngại về tăng trưởng chậm, cạnh tranh từ chip AI tùy chỉnh của các công ty công nghệ lớn và rủi ro gián đoạn kinh doanh tại Trung Quốc từ chính quyền Donald Trump mới nhậm chức ở Mỹ.

Bất chấp các hạn chế từ chính phủ Mỹ về khả năng của chip AI bán tại Trung Quốc, ByteDance và Tencent vẫn nổi lên là hai trong số những khách hàng lớn nhất của Nvidia trong năm nay.

Microsoft, với khoản đầu tư 13 tỷ USD vào OpenAI, đã tỏ ra là công ty công nghệ lớn của Mỹ đầu tư mạnh mẽ nhất vào hạ tầng trung tâm dữ liệu, nhằm hỗ trợ các dịch vụ AI của mình như trợ lý Copilot, đồng thời cung cấp dịch vụ đám mây cho khách hàng thông qua Azure.

Số lượng chip Nvidia mà Microsoft đặt mua năm nay cao gấp ba lần số chip cùng thế hệ mà họ mua vào năm 2023, thời điểm Nvidia đẩy mạnh sản xuất Hopper sau khi ChatGPT tạo được tiếng vang lớn.

CHI PHÍ HẠ TẦNG AI VÀ SỰ GIA NHẬP CỦA CÁC CÔNG TY MỚI

Dự kiến năm 2024, các công ty công nghệ trên toàn cầu sẽ chi tổng cộng 229 tỷ USD vào máy chủ, theo Omdia, trong đó Microsoft dẫn đầu với khoản chi 31 tỷ USD, tiếp theo là Amazon với 26 tỷ USD. Top 10 công ty đầu tư hạ tầng trung tâm dữ liệu, bao gồm cả các tân binh như xAI và CoreWeave, chiếm 60% tổng chi tiêu toàn cầu vào năng lực điện toán.

Vlad Galabov, Giám đốc nghiên cứu đám mây và trung tâm dữ liệu tại Omdia, cho biết 43% chi tiêu vào máy chủ năm 2024 được dành cho Nvidia. “Chip GPU của Nvidia chiếm một phần cực lớn trong ngân sách máy chủ,” ông nói. “Chúng ta đang tiến gần đến đỉnh cao".

Mặc dù Nvidia vẫn thống trị thị trường chip AI, đối thủ AMD đang dần giành thị phần. Meta đã mua 173.000 chip MI300 của AMD trong năm nay, trong khi Microsoft mua 96.000 chip, theo Omdia.

Các công ty công nghệ lớn cũng gia tăng sử dụng chip AI tự phát triển trong năm nay, nhằm giảm phụ thuộc vào Nvidia. Google, với dòng chip Tensor Processing Units (TPUs) phát triển trong suốt một thập kỷ, và Meta, với chip Meta Training and Inference Accelerator thế hệ đầu tiên ra mắt năm ngoái, mỗi công ty đã triển khai khoảng 1,5 triệu chip.

Amazon, công ty đầu tư mạnh vào chip Trainium và Inferentia cho khách hàng điện toán đám mây, đã triển khai khoảng 1,3 triệu chip này trong năm nay. Amazon cũng thông báo sẽ xây dựng một cụm mới với hàng trăm nghìn chip Trainium để hỗ trợ Anthropic – đối thủ của OpenAI mà Amazon đã đầu tư 8 tỷ USD – đào tạo thế hệ mô hình AI tiếp theo.

Microsoft, tuy nhiên, vẫn ở giai đoạn đầu trong nỗ lực phát triển chip AI tùy chỉnh để cạnh tranh với Nvidia, với khoảng 200.000 chip Maia được cài đặt trong năm nay.

Alistair Speirs, Giám đốc cấp cao của Azure Global Infrastructure tại Microsoft, cho biết: “Việc xây dựng hạ tầng AI không chỉ đơn giản là sở hữu chip tốt nhất, mà còn cần có các thành phần lưu trữ phù hợp, lớp hạ tầng đúng chuẩn, phần mềm quản lý tối ưu, sửa lỗi và nhiều yếu tố khác để tạo thành một hệ thống hoàn chỉnh”.

Khám phá làn sóng đầu tư vào trung tâm dữ liệu AI tại châu Á, với Indonesia và Việt Nam dẫn đầu trong cuộc đua công nghệ.

Trung Quốc ghi nhận 1.434 tỷ phú mới, với tài sản tăng mạnh từ công nghệ và chứng khoán trong năm 2025.

OpenAI ra mắt ChatGPT Atlas, thách thức Google trong cuộc đua kiểm soát tương lai Internet.

Nền kinh tế Mỹ dưới thời Trump: AI hút vốn, cản trở phục hưng sản xuất. Tìm hiểu sự chuyển mình tại Lordstown.

Nhà nghiên cứu AI ở Silicon Valley làm việc cực đoan 80-100 giờ/tuần, chạy đua giành ưu thế trong cuộc cách mạng trí tuệ nhân tạo.

Chính quyền Trump mở rộng can thiệp vào công nghệ, đàm phán nắm cổ phần các công ty điện toán lượng tử để hỗ trợ phát triển.

Khám phá cách OpenAI gắn kết số phận với các gã khổng lồ công nghệ và thách thức trong cuộc đua AI.

Mỹ đang siết chặt nhập cư nhưng vẫn cần nhân tài AI từ Trung Quốc. Ai sẽ dẫn đầu trong cuộc đua công nghệ?

Khám phá cách trí tuệ nhân tạo đang làm chậm quá trình chuyển đổi xanh do cơn khát năng lượng. Đọc ngay để hiểu rõ hơn!

Khám phá xu hướng IPO tại Trung Quốc, nơi xe điện, chip bán dẫn và robot trở thành trụ cột của chiến lược công nghiệp mới.